在人工智慧(AI)技術以前所未有的速度發展的今天,一個被譽為「AI 界的 GitHub」的ai平台正迅速成為全球開發者與研究人員的聚集地——它就是 Hugging Face。

這個平台不僅僅是一個儲存庫,更是一個完整、活躍且致力於「AI 民主化」的生態系統。從最初的聊天機器人應用,到如今獲得 Google、Amazon、Nvidia 等科技巨頭機構投資,估值數十億美元的 AI 獨角獸,Hugging Face 的崛起象徵著開源精神在 AI 領域的勝利。

本文將深入剖析 Hugging Face 的起源、核心組件、實戰應用、商業模式及其背後的理念,為您提供一份全方位的詳盡指南,無論您是 AI 新手還是資深開發者,都能在此找到有價值的資訊。

Hugging Face 的起源與理念 — 不只是一個擁抱的表情

創業歷史與關鍵轉型

Hugging Face 於 2016 年由 Clément Delangue、Julien Chaumond 及 Thomas Wolf 共同創立。令人意外的是,它最初的產品並非今日我們所熟知的開發者平台,而是一款針對青少年市場、主打情感支持與有趣對話的社交聊天機器人 App。然而,當時的自然語言處理(NLP)技術尚未成熟,這款應用也遲遲未能找到可持續的商業模式。

真正的轉捩點發生在 Google 於 2017 年發表了劃時代的論文《Attention Is All You Need》,介紹了日後成為大型語言模型(LLM)核心的「Transformer」架構。大約在同一時期,Hugging Face 團隊做出了一個關鍵決定:將他們為聊天機器人開發的 NLP 模型開源。

這一舉動恰好迎合了當時機器學習社群對於高效能、可複用模型工具的迫切需求,尤其是對於那些因缺乏龐大運算資源而無法從零開始訓練 Transformer 模型的個人開發者和中小型企業。開源的模型庫迅速爆紅,Hugging Face 也因此順勢轉型,從一家 B2C 的應用公司,徹底轉變為一個專注服務開發者、推動開源 AI 的平台,其目標就是讓先進技術普及化。

「AI 民主化」的核心使命

Hugging Face 的核心經營理念是「AI 民主化」(Democratize good machine learning)。相較於 OpenAI、Google 等巨頭傾向於建立封閉的、以 API 為主的「圍牆花園」,Hugging Face 選擇了一條截然相反的道路。他們致力於打破技術壟斷,讓無論是初學者還是頂尖研究者,都能夠平等、方便地接觸和使用最先進的 AI 技術。這個致力於推動資訊科技進步的平台,就是Hugging Face。

這個理念或許可以追溯到創辦人 Clément Delangue 的早期經歷,他曾倡導教育的開放與普及。Hugging Face 正是將這種精神應用在 AI 領域,透過建立一個全球化的社群,讓開發者能夠自由地共享預訓練模型、資料集與知識,共同推動 AI 技術的普及與進步。

名字與 Logo 的意義

公司的名稱與其標誌性的「擁抱臉(🤗)」表情符號,完美詮釋了其品牌理念。這個 Logo 不僅呼應了創業初期針對年輕人的產品定位,更深層的意義在於它象徵著「人與機器的友善溝通」。它既包含了電腦科技的元素,又展現了人類「擁抱」這一充滿情感的姿態,傳達了讓 AI 以更親民、更人性化的方式融入生活的願景。

Hugging Face 生態系核心組件詳解

Hugging Face 的強大之處在於其圍繞 Hugging Face Hub 建立了一套完整且高度整合的工具鏈。這些代碼工具與函式庫互相協作,極大地簡化了 AI 開發的複雜流程。

Hugging Face Hub:AI 資產的中心

Hub 是整個生態系統的心臟,一個集中式的協作平台。您可以將其視為專為機器學習打造的 GitHub。截至 2024 年底,Hub 已託管了超過 90 萬個模型、20 萬個資料集,以及大量的應用展示(Spaces),其中也包含了許多示範檔案。

- Models:匯集了來自全球的模型,涵蓋 NLP、電腦視覺、語音處理、多模態等多種任務。使用者可以輕鬆搜尋、篩選,甚至直接在網頁上測試模型效果。

- Datasets:提供了海量的標準化數據集,使用者無需再為資料搜集與前處理煩惱,可直接載入用於模型訓練與評估,其豐富度可媲美一個龐大的資料庫。

- Spaces:提供了一個平台,讓開發者可以輕鬆建立、部署和分享由 AI 模型驅動的 Web 應用程式。這對於展示專案成果、打造互動式 Demo 極為方便,甚至可用來託管靜態網頁空間。

關鍵函式庫(Key Libraries)

- Transformers:是Hugging Face最核心、最受歡迎的開源函式庫,也常被稱為 hugging face transformers。它為數千個基於 Transformer 架構的預訓練模型(如 BERT, GPT, T5 等)提供了統一、標準化的介面。其最大的優勢在於「標準化」,開發者在更換不同模型時,往往只需修改一行載入模型的程式碼,而無需重寫整個處理流程,極大地提升了開發與實驗的效率。

- Tokenizers:在自然語言處理中,模型無法直接理解文字,必須先將其轉換為數字。Tokenizer(分詞器),有時也稱為標記器,就是執行這項關鍵任務的工具。它負責將文本分解為模型能夠理解的最小單位(Tokens),並將其對應到數字 ID。Hugging Face Tokenizers 這款 hugging face library 提供了多種高效的分詞演算法,能夠快速處理大規模文本資料,是所有 NLP 任務不可或缺的前置步驟。

- Datasets:這個函式庫讓資料的存取與處理變得前所未有的簡單,此函式庫即為 hugging face datasets。它支援對龐大資料集(即使是 TB 等級)進行高效的記憶體對映(Memory Mapping),避免一次性載入所有資料而耗盡記憶體。同時,它內建了豐富的資料處理方法,如篩選、映射、排序等,可以與 Pandas、NumPy 等工具無縫整合。

- Diffusers:專為生成式 AI 設計的函式庫,特別是在圖像和音訊生成領域。與 DALL-E 或 Stable Diffusion 類似,開發者可以使用 Diffusers 函式庫,透過簡單的文字描述來生成高品質的圖像,或進行圖像編輯、風格轉換等任務。

- Accelerate & Optimum:這兩個函式庫專注於效能最佳化。Accelerate 能夠讓使用者僅需修改幾行程式碼,就能輕鬆地將 PyTorch 訓練腳本擴展到多 GPU、TPU 或混合精度訓練環境中。Optimum 則專注於提升模型在特定硬體上的推理(Inference)效能,將模型轉換為 ONNX 或 TensorRT 等格式,以達到更快的速度和更低的延遲。

Hugging Face 實戰教學 — 從零開始運行你的第一個 AI 模型

理論知識固然重要,但親手實踐才能真正體會 Hugging Face 的便捷。本章節將以一個對非技術人員也友善的方式,帶您從零開始,在 Hugging Face Spaces 上運行一個小型語言模型,並了解其基本工作原理。

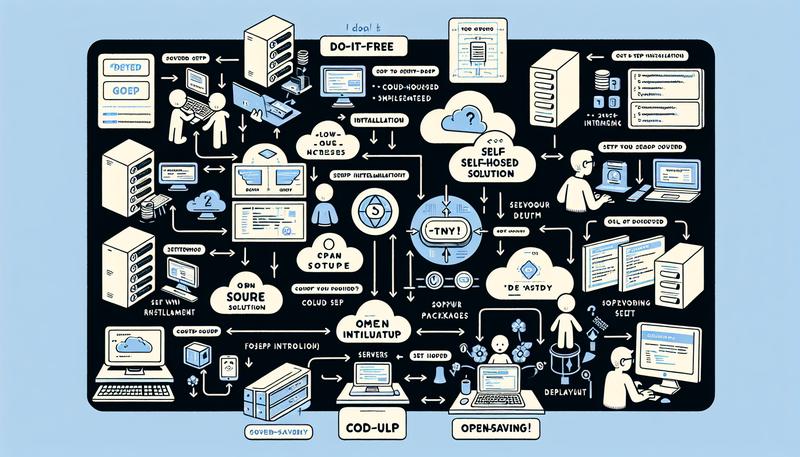

事前準備:註冊與環境設定

創建 Hugging Face 帳號:前往 huggingface.co 官網,點擊 “Sign Up” 完成註冊。

創建 Space:登入後,點擊頁面頂部的 “Spaces”,然後選擇 “Create New Space”。

配置 Space:

- Space name:為您的專案取一個獨一無二的名稱。

- License:選擇一個開源授權協議。

- Select the Space SDK:選擇 “Docker”,然後從下拉選單中找到並選擇 “JupyterLab”。這將為我們建立一個預配置好的互動式程式設計環境。

- Space hardware:運行大型語言模型通常需要 GPU 加速。預設的 CPU 是免費的,但對於 LLM 來說可能非常慢或無法運行。您可以選擇一個付費的 GPU 硬體,例如 “NVIDIA A10G Small”。請注意:選擇付費硬體會產生費用,Hugging Face 會要求您綁定信用卡資訊。費用按小時計,不用時記得手動關閉 Space 以停止計費。

- 點擊 “Create Space”,平台會開始建置您的環境。

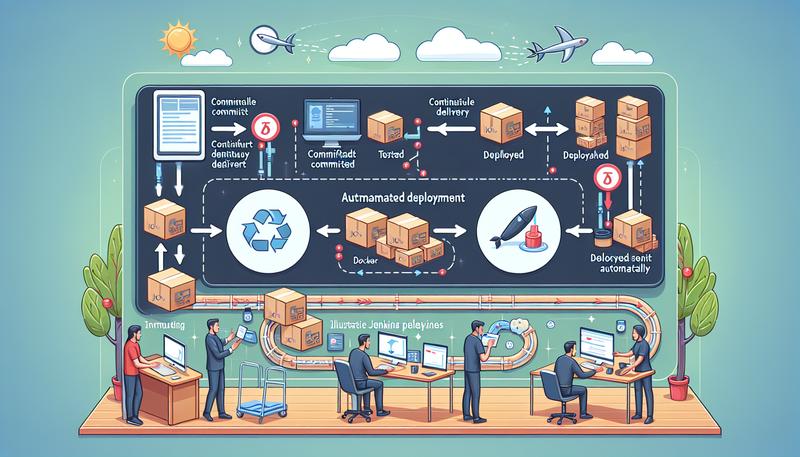

步驟一:安裝必要的函式庫

環境建置完成後,您會看到 JupyterLab 的介面。

- 在 Launcher 頁面,點擊 “Notebook” 下的 “Python 3” 圖示,創建一個新的 Notebook 檔案。

- 在第一個儲存格(cell)中,輸入以下指令來安裝 transformers library 以及其依賴的後端框架 PyTorch。!pip 是在 Notebook 中執行終端機指令來安裝 Python套件(也稱 Python包)的方式。

!pip install transformers torch- 點擊上方的 “▶” 執行按鈕(或按下 Shift + Enter),等待安裝完成。

步驟二:載入模型與分詞器 (Tokenizer)

- 在新的儲存格中,我們需要從 transformers庫 中導入我們需要的工具——AutoTokenizer 和 AutoModelForCausalLM。Auto 類別可以根據模型名稱自動識別並載入對應的架構。

from transformers import AutoTokenizer, AutoModelForCausalLM- 接著,定義我們要使用的模型 ID。我們選擇微軟開發的小型但功能強大的 phi-2 模型。這個 ID 對應著它在 Hugging Face Hub 上的儲存庫路徑。

model_id = "microsoft/phi-2"- 使用 .from_pretrained() 方法來實例化並下載模型與分詞器。這一步可能需要幾分鐘,因為它會從 Hub 下載數 GB 的模型檔案到您的 Space 中。每個模型版本都可能有所不同。

# 載入分詞器

# 註:phi-2 模型需要信任遠端程式碼,因此需設定 trust_remote_code=True

tokenizer = AutoTokenizer.from_pretrained(model_id, trust_remote_code=True)

# 載入模型

model = AutoModelForCausalLM.from_pretrained(model_id, trust_remote_code=True)- 小知識:phi-2 是一個「基礎模型」(Base Model),而非「指令微調模型」(Instruction-Tuned Model)。這意味著它擅長的是根據前文「續寫」文本,而不是像 ChatGPT 那樣遵循明確的指令進行對話。

步驟三:準備輸入並生成結果

- 現在,讓我們準備要輸入給模型的文字提示(prompt),也就是 input_text。

input_text = "Once upon a time, in a land far, far away,"- 使用分詞器將語言文字轉換為模型能理解的數字 ID。return_tensors=”pt” 表示我們希望輸出為 PyTorch 張量(Tensor)格式。

input_ids = tokenizer(input_text, return_tensors="pt").input_ids- 呼叫模型的 .generate() 方法來生成文本。max_new_tokens 參數限制了模型生成新詞的最大數量。

outputs = model.generate(input_ids, max_new_tokens=50)- 模型的輸出同樣是數字 ID,我們需要使用分詞器的 .decode() 方法將其轉換回人類可讀的文字。

decoded_outputs = tokenizer.decode(outputs[0])- 最後,將結果 text 印出查看。

print(decoded_outputs)您會看到模型基於 “Once upon a time…” 開頭,續寫了一段富有想像力的故事。這完美地展示了基礎模型的「自動補全」特性。恭喜您,已經成功運行了第一個 Hugging Face 上的語言模型!

多元的應用與費用方案

Hugging Face 的價值遠不止於模型託管和函式庫,其延伸的服務和清晰的定價模式使其能夠滿足從個人愛好者到大型企業的各種需求。

HuggingChat 與 HuggingGPT

需要釐清的是,HuggingChat 和 HuggingGPT 是兩個不同的概念。

- HuggingChat:這是由 Hugging Face 官方推出的、類似於 ChatGPT 的對話式 AI 介面。使用者可以直接在網頁上與多種開源模型進行對話,它甚至還推出了 macOS 的原生桌面應用程式。

- HuggingGPT:這是一個由浙江大學和微軟研究院合作提出的研究框架。其核心思想是利用一個大型模型(如 ChatGPT)作為控制器,來分析使用者複雜的需求,並從 Hugging Face Hub 上自動選擇、調度多個專業模型協同完成任務,最後整合結果。它展示了將 Hub 作為一個「模型即服務」的調度中心的前景。

費用方案詳解

Hugging Face 採取了免費增值(Freemium)的模式,核心功能對社群免費開放,同時提供付費方案以滿足進階需求。

| 方案 / 服務 | 費用(美元) | 方案說明 |

|---|---|---|

| HF Hub | 免費 | 核心協作平台。提供無限的公開模型、資料集和 Spaces 儲存庫,以及完整的社群功能。 |

| Pro Account | $9 / 月 | 為個人使用者設計。解鎖進階功能,如私有儲存庫、無伺服器推論(Inference API)的更高用量限制,以及搶先體驗新功能。 |

| Enterprise Hub | $20 / 每位使用者 / 月 | 為團隊和企業設計。提供進階的安全性控制(如 SSO)、權限管理、數據位置控制以及優先技術支援。 |

| Spaces Hardware | 從 $0 / 小時起 | 為 Spaces 應用升級運算資源。提供從免費 CPU 到各種等級 GPU 及加速器的硬體選項,按實際使用時間計費。 |

| Inference Endpoints | 從 $0.032 / 小時起 | 在託管的專用基礎設施上部署模型,適用於生產環境。提供自動擴展、企業級安全性和低延遲的 API 服務。 |

第五章:商業模式與未來展望

開源社群的變現之道

Hugging Face 的商業模式常被拿來與 Red Hat(在 Linux 上提供企業服務)或 GitHub(在 Git 上提供協作平台)類比。他們並不直接「販售」開源模型,而是透過在龐大且活躍的開源社群基礎上,提供增值服務來獲利。這包括:

- 便利性與效能:為企業提供付費的、易於管理且高效能的模型託管(Inference Endpoints)和運算資源(Spaces Hardware)。

- 安全性與合規性:透過 Enterprise Hub 提供企業所需的安全、權限和稽核功能。

- 支援與專業服務:為企業客戶提供專家級的技術支援。

創辦人曾自信地表示,當機器學習成為打造技術的預設方式時,作為該領域首選平台的 Hugging Face,很難想像無法創造數十億美元的收益。他們的策略是先透過開放和低門檻的工具佔領市場、培養社群,當社群和生態足夠龐大時,即使只有一小部份使用者轉化為付費客戶,也能支撐起穩固的商業模式。

挑戰與未來

Hugging Face 最大的挑戰並非來自功能相似的平台,而是來自封閉 AI 模型的持續領先。如果 OpenAI 的 GPT 系列或 Google 的 Gemini 系列等封閉模型在性能上始終大幅超越所有開源模型,開發者可能會更傾向於直接使用這些封閉的 API。因此,Hugging Face 的未來與整個開源 AI 生態的榮衰緊密相連。

也正因如此,Hugging Face 大力推動開源模型的發展,資助 BigScience 計畫(催生了 BLOOM 模型),並與 Meta 等公司合作推廣 Llama 等開源模型。他們相信,一個開放、透明、協作的 AI 生態不僅更有利於技術的快速迭代和安全對齊,也將為他們創造更大的商業機會。

常見問題 (FAQ)

Q1: Hugging Face 是完全免費的嗎?

A: 核心功能是免費的。您可以免費使用和貢獻公開的模型、資料集和 Spaces。付費服務主要針對進階需求,包括:

1. Pro/Enterprise 帳號,提供私有儲存庫、更高的 API 限制和企業級安全功能;

2. 付費硬體,如為 Spaces 或 Inference Endpoints 租用 GPU 進行模型訓練或部署。

Q2: 我需要具備程式設計能力才能使用 Hugging Face 嗎?

A: 不完全需要。您可以在 Hugging Face 網站上直接探索、測試許多模型提供的互動式介面(Spaces)。然而,若要將模型整合到您自己的應用程式、進行模型微調或執行更複雜的任務,具備 Python 程式設計知識是必要的。同時,平台也提供了如 AutoTrain 這樣的低程式碼工具,進一步降低了使用門檻。

Q3: Hugging Face 和 OpenAI (ChatGPT) 有什麼不同?

A: 主要區別在於定位和理念。OpenAI 主要是一家 AI 研究與產品公司,他們開發自己的大型、閉源模型(如 GPT-4),並透過付費 API 的形式提供服務。而 Hugging Face 是一個開放平台,它不主要開發自己的模型,而是匯集了來自全球各地的組織(如 Google, Meta, Microsoft 及開源社群)發布的數十萬個模型,並提供一套標準化的開源工具(如 Transformers 函式庫)來幫助大家使用這些模型。簡言之,一個是「封閉的生產者」,另一個是「開放的生態平台」。

Q4: 什麼是分詞器 (Tokenizer),為什麼它很重要?

A: 分詞器是一個至關重要的工具,它的工作是將人類的自然語言文本(如一個句子)分解成更小的單位(稱為 “tokens”,可以是單詞或子詞),並將每一個 token 轉換為一個獨特的數字 ID。這個過程是必需的,因為 AI 模型只能理解和處理數字數據,無法直接處理文字。每個模型都有其在訓練時使用的特定分詞器,因此在應用模型時,必須使用與之配對的同一個分詞器,才能確保模型正確理解輸入的含義。

Q5: 我可以在 Hugging Face 上訓練自己的模型嗎?

A: 當然可以。Hugging Face 的生態系統完全支持模型訓練。常見的做法是「微調」(Fine-tuning),即選擇一個在 Hub 上的強大預訓練模型,然後用您自己的特定資料集在其基礎上進行額外訓練,使其更適應您的任務。您可以使用 Transformers 和 Datasets 函式庫來完成這一過程,並利用 Spaces 提供的硬體資源進行訓練。訓練完成後,您還可以將自己微調好的模型上傳到 Hub,與社群分享或在自己的應用中部署。

總結

Hugging Face 早已超越了「AI 界的 GitHub」這個簡單的標籤。它是一個集模型中心、標準化工具鏈、應用展示平台和全球開發者社群於一體的綜合性生態系統。透過堅持「AI 民主化」的理念,Hugging Face 大幅降低了 AI 技術的入門門檻,讓無數開發者和研究者得以站在巨人的肩膀上進行創新。

它不僅是程式碼和模型的橋樑,更是連接開發者、AI 模型與商業化應用的關鍵樞紐。在可預見的未來,Hugging Face 將繼續在推動開放、協作、透明的 AI 新時代中,扮演至關重要的角色。

資料來源

- Hugging Face 是什麼?全面了解Hugging Face AI 特色與 …

- 什麼是Hugging Face?開源AI 平台介紹4 點加速AI 開發

- 本章簡介- Hugging Face LLM Course