大型語言模型(LLM)作為人工智慧領域的一項重要突破,為我們的生活帶來了前所未有的變革。這些模型以其深度學習能力,能夠有效理解並生成自然語言,廣泛應用於文本生成、對話系統、語言翻譯等多個領域。隨著技術的不斷進步,LLM的應用範圍亦日益擴大,甚至在自動駕駛等尖端領域展現潛力。本文將深入探討LLM的基本概念、參數結構及建立流程,幫助讀者理解這項技術的核心要素與應用潛力。

LLM AI 是什麼?

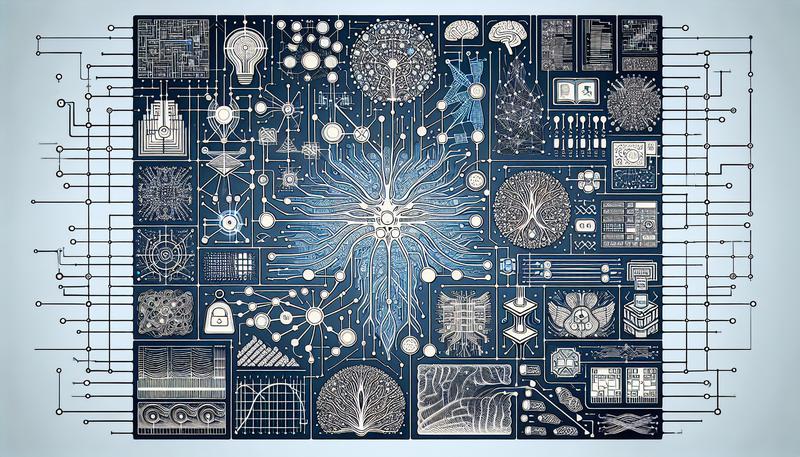

大型語言模型(Large Language Model,LLM)是人工智慧(AI)領域中的一種深度學習模型,專門設計來處理人類語言的理解和生成。這類模型透過吸收和學習龐大的文本數據,具備分析、生成及預測語句的能力。LLM 的訓練過程需要大量數據支持,通常包含書籍、網站、新聞等各類文本,使模型能夠掌握語言的結構和語境。

LLM 是基於 Transformer 架構的神經網路技術。Transformer 的「自我注意力」機制使模型能夠識別和理解上下文中的字詞關係,因此可以生成符合語法並富有邏輯的句子。這些模型被應用於許多場景,包括文本生成、語言翻譯、對話式 AI(如 Alexa 和 Siri)、程式碼撰寫等。

在現實應用中,LLM 幫助自動化客戶服務、內容生成,並可用於研究和教育等領域。

LLM參數是什麼?

在大型語言模型(Large Language Model,LLM)中,參數是模型核心運算的關鍵元素。這些參數主要是數字值,調整模型如何處理和生成語言資料。常見的參數包括「權重」和「偏差」,它們在模型訓練過程中被反覆調整,以優化模型對文字資料的理解和生成能力。LLM中的參數量級通常達到數十億級別,如 GPT-3 擁有 175 億個參數,而 GPT-4 可能更為龐大。

LLM的主要參數分為三種:權重(weights)、偏差(biases)和嵌入向量(embedding vectors)。這些參數通過深度學習架構(如 Transformer)中的「自我注意力」機制來識別詞與詞之間的關聯性,使得模型能夠生成連貫的文本。

此外,模型的運作還涉及一些重要的「超參數」,如溫度(Temperature)、詞彙概率選擇(Top P)等,這些超參數影響生成文本的創造性和一致性,並可以根據不同應用需求進行調整。

如何建立LLM?

建立大型語言模型(LLM)是一個複雜且資源密集的過程,通常包括數個階段:資料收集、模型設計、訓練和微調、以及部署。以下是詳細步驟:

- 資料收集與準備:LLM需要大量高品質文本資料。此步驟包括收集並清理符合需求的資料集,常見的來源有網頁文本、文學作品、技術文件等。許多項目還會利用「嵌入向量」技術將文字轉化為模型能理解的數值形式,以便在神經網路中進行處理。

- 模型設計與基礎架構:大多數LLM使用Transformer架構,這是一種高度平行化的神經網路,能夠有效處理大規模語言資料。開源工具如Hugging Face的Transformers框架提供了許多模型架構,可以幫助開發者快速設計LLM。

- 模型訓練與微調:訓練模型需要大量的計算資源,通常使用GPU或TPU集群。訓練過程中,模型透過調整「權重」和「偏差」等參數,不斷優化對資料的理解和預測能力。訓練後,可以進行「監督微調」(SFT)和「增強學習」(RL),如使用人類偏好回饋(RLHF)來進一步提升模型性能。增強學習策略如PPO(Proximal Policy Optimization)等,有助於模型在不大幅改變原生成能力的情況下調整回覆表現。

- 模型部署與優化:訓練好的模型可以部署在雲端或本地環境中,根據應用需求選擇合適的部署策略。部署後,開發者需進行效能調整,確保模型在回應速度、資源消耗和準確性之間取得平衡。

透過這些步驟,開發者可以從無到有地構建一個專屬的LLM模型,為應用場景提供定製化的語言理解與生成能力。

總結

大型語言模型(LLM)是人工智慧領域中的一種深度學習模型,專注於人類語言的理解和生成。LLM使用龐大的文本數據進行訓練,通常基於Transformer架構,利用自我注意力機制來識別和理解字詞關係,生成符合語法的文本。LLM擁有數十億的參數,包括權重和偏差,這些參數在訓練過程中不斷調整,以優化語言處理能力。